Dieser praktische Leitfaden zeigt dir, wie du die WireGuard-Leistung auf einem VPS oder dedizierten Server messen und maximieren kannst. Du erstellst eine zuverlässige Basis für den Tunnel-Benchmark, korrigierst Variablen mit großer Auswirkung (MTU/MSS, parallele Streams, GRO/GSO, CPU-Tuning) und konfigurierst eine saubere, reproduzierbare Server-Schnittstelle. Anschließend behandeln wir einige fortgeschrittene Konzepte wie Offload-Aware-Tunneling, Parallelität, NUMA/Frequenz und Details zur Netzwerktopologie und schließen mit einem kurzen FAQ ab. Anhand der Checklisten und verifizierten Befehle lassen sich theoretische Erkenntnisse in wiederholbare Ergebnisse umsetzen.

Einführung: Volle WireGuard Leistung entfesseln

Die Leistung von WireGuard kann außergewöhnlich sein, wenn du sie richtig konfigurierst. WireGuard ist zwar von Grund auf schnell, doch um Spitzenwerte zu erreichen, müssen wichtige Faktoren berücksichtigt werden: CPU-Eigenschaften, korrekte MTU-Einstellungen und strenge Benchmarking-Methoden. Viele Leistungsprobleme von WireGuard sind auf einfache Fehlkonfigurationen zurückzuführen, wie z. B. eine falsche MTU (Maximum Transmission Unit), die Pakete fragmentiert, oder Single-Stream-Tests, die Multi-Core-Fähigkeiten außer Acht lassen.

Nach jeder Änderung unbedingt testen, um Verbesserungen sicherzustellen und einen klaren Rollback-Pfad zu gewährleisten.

Die Technologie hinter WireGuard’s Geschwindigkeit: Warum es schneller ist

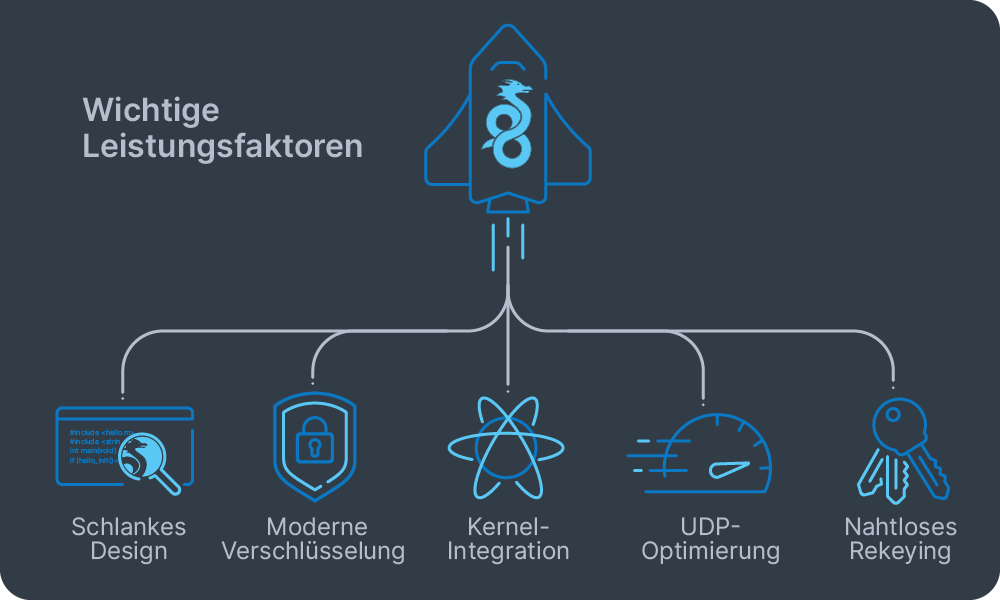

Die Geschwindigkeit von WireGuard ergibt sich aus drei grundlegenden Design-Ideen: Einfachheit, moderne Kryptographie und intelligente Platzierung im Betriebssystem. Das Verständnis dieser Faktoren hilft zu erklären, warum WireGuard konsequent herkömmliche VPN-Protokolle übertrifft.

WireGuard erreicht seine Leistung durch mehrere Schlüsselfaktoren:

- Schlankes Design: ~4.000 Zeilen Code (im Vergleich zu mehreren Zehntausend von OpenVPN), was Audits und Optimierungen einfacher macht.

- Moderne Verschlüsselung: Verwendet ChaCha20-Poly1305, das auf allen Prozessoren effizient läuft, im Gegensatz zu AES, das für optimale Geschwindigkeit Hardwarebeschleunigung (AES-NI) benötigt.

- Kernel-Integration: Verarbeitet Pakete ohne aufwendige Kontextwechsel.

- UDP-Optimierung: Nutzt integrierte Funktionen zur Netzwerkbeschleunigung.

- Nahtloses Rekeying: Schlüssel rotiert automatisch alle paar Minuten oder nach Nachrichtenschwellen über kurze Handshakes, ohne die Flows zu unterbrechen.

Mit Multi-Queue-Netzwerkkarten können verschiedene Verbindungsflüsse auf mehrere CPU-Kerne verteilt werden. Das bedeutet, dass WireGuard die Leistung durch parallele Verarbeitung skalieren kann, anstatt die Grenzen eines einzelnen Kerns zu erreichen.

Befehle zur Leistungsüberprüfung

Bevor du mit der Optimierung beginnst, vergewissere dich, dass dein System den schnellen Pfad verwendet, für den WireGuard entwickelt wurde:

Überprüfe die Kernel-Version (WireGuard ist erst ab 5.6 integriert):

uname –r Überprüfe das WireGuard-Modul:

modinfo wireguard

lsmod | grep wireguard

sudo modprobe wireguard Überprüfe die Netzwerk-Offloads:

ethtool -k eth0 | grep -E 'gro|gso|tso' Teste die Multi-Core-Skalierung:

iperf3 -P 4 WireGuard-Benchmark: Mehr als ein einfacher Geschwindigkeitstest

Ein zuverlässiger WireGuard-Benchmark erfordert weit mehr als einen schnellen WireGuard-Geschwindigkeitstest oder eine Messung mit einem einzelnen Stream. Der Goldstandard ist ein methodischer Vergleich zwischen dem Durchsatz ohne VPN und der Leistung des WireGuard-Tunnels unter Verwendung paralleler Streams, um die Multi-Core-Skalierung des Protokolls zu zeigen, sowie die Messung des TCP- und UDP-Verhaltens. Konsistenz ist entscheidend: Die Testbedingungen (Hosts, Routen, MTU, Stream-Anzahl und Dauer) müssen in beiden Szenarien identisch sein, damit die Ergebnisse sinnvoll sind.

In den meisten Fällen ist iperf3 das primäre Werkzeug zur Messung des TCP (Transmission Control Protocol) und UDP (User Datagram Protocol) Durchsatzes mit sowohl einem einzelnen als auch mehreren gleichzeitigen Streams (-P). irtt ist wertvoll für die eingehende Analyse von Latenz und Jitter, während einfache Systemzähler (wie top, mpstat, oder ip -s link) dabei helfen, CPU- oder Paketverluste während der Tests anzuzeigen. Optionale Werkzeuge wie Netdata können ein Dashboard in Echtzeit bereitstellen, sind jedoch keine Voraussetzung für eine solide Benchmarking.

Testen der Cores

Beginne mit einem iperf3-Test zwischen Client- und Server-Endpunkten über das unverschlüsselte Netzwerk, ohne WireGuard. Messe den Durchsatz sowohl mit einem einzelnen Stream (ip -s link) als auch mit parallelen Streams (-P 4 oder -P 8) um herauszufinden, ob durch einen Flow eingeschränkt bist oder die Multi-Core-Skalierung nutzen könntest.

Binde dann den iperf3-Server an deinen Tunnel-Endpunkt (z.B. 10.0.0.1 mit -B auf dem Server) und wiederhole die gleichen Tests durch den WireGuard-Tunnel. Wiederhole jede Messung in beiden Richtungen – du kannst die Rückwärtsoption von iperf3 verwenden (-R) – da die Tunnel-Leistung asymmetrisch sein kann. Für UDP stelle eine explizite Bandbreite (-u, -b) ein und überwache den Verlust, um den maximalen Durchsatz zu schätzen.

Ein möglichst konsistentes Testumfeld sicherstellen: Beide Hosts stabil halten (verkabelt und beim gleichen Anbieter / in derselben Region), eine feste Testdauer festlegen und Hintergrundlast vermeiden. Um stabile Ergebnisse zu erzielen, muss die CPU-Skalierung während der Ausführung auf „Performance“ eingestellt werden.

Ergebnisse interpretieren

Die wichtigste Erkenntnis aus dem WireGuard-Benchmark ergibt sich aus dem Vergleich von Baseline- vs. Tunnel-Leistung, insbesondere mit parallelen Streams. Wenn WireGuard bei parallelen Tests in etwa dem unverschlüsselten Netzwerk entspricht, ist die Konfiguration auf deine Hardware abgestimmt. Wenn es einen signifikanten Rückgang gibt, überprüfe MTU/MSS (auf Fragmentierung), Offload-Funktionen (GRO/GSO) und die CPU-Sättigung pro Kern, bevor du tiefergehende Änderungen vornimmst.

Variablen zur Leistungsoptimierung bei WireGuard

Um großartige Ergebnisse zu erzielen, braucht es nicht nur einen einzigen magischen Schalter, sondern die richtige Reihenfolge einiger wichtiger Variablen für die Leistungsoptimierung von WireGuard. Verwende diesen Abschnitt als schnelle Checkliste, die du für den Vergleich von Baseline- und Tunneldurchsatz anwenden kannst.

Was zu optimieren ist (und wie)

| Variable | Warum es wichtig ist | Schnelltest | Beheben |

| MTU/MSS | Falsche MTU verursacht Fragmentierung und TCP-Störungen | Überwache die TCP-Neuübertragungen während der Tests | MTU in [Interface] festlegen (nach PMTU-Test); nur beim Routing von Subnetzen: TCP MSS beim Ausgang auf PMTU begrenzen |

| Parallelität | Einfache Streams erreichen Limitierungen per Flow; parallele Streams verwenden mehrere Kerne | Vergleiche iperf3 -P 1 vs -P 4/8 | Beurteile die Kapazität mit -P 4/8; unterteile Massenübertragungen |

| CRO/GSO-Offloads | Batching reduziert die CPU-Kosten pro Paket für UDP-Tunnel | Überprüfe den Offload-Status; korreliere ihn mit der CPU-Auslastung | Stelle mit ethtool sicher, dass GRO/GSO aktiviert ist |

| CPU-Skalierung | Krypto ist CPU-gebunden; Frequenzeinbrüche begrenzen die Geschwindigkeit | Beobachte die Nutzung pro Kern während der Tests | Setze den CPU-Governor auf „performance“ |

| Systemengpässe | Alte Kerne/Treiber und schlechte Queue-Distribution begrenzen die Skalierung | Überprüfe die Kernel-Version; teste, ob If -P skaliert | Verwend moderne Kerne; bevorzuge Multi-Flows |

Wichtige Befehle

MSS-Clamping (für Subnetz-Routing):

sudo iptables -t mangle -A FORWARD -o wg0 -p tcp --tcp-flags SYN,RST SYN -j TCPMSS --clamp-mss-to-pmtu Überprüfe die Offloads:

sudo ethtool -k eth0 | grep -E 'gro|gso' System-Buffer:

# /etc/sysctl.d/99-wireguard.conf

net.core.rmem_max = 134217728

net.core.wmem_max = 134217728

net.core.netdev_max_backlog = 250000 Wir lernen: WireGuards Kryptografie ist fest verdrahtet (keine Cipher-Auswahl). PersistentKeepalive hilft bei der NAT-Traversierung, nicht bei der Geschwindigkeit. Die meisten Verbesserungen lassen sich durch MTU-Korrektheit, Offloads und Parallelität erzielen – optimiere diese Aspekte, bevor du dich an die erweiterten Kernel-Optimierung machst.

Konfiguration das WireGuard Server-Interface

Um deinen WireGuard Server für optimale Leistung zu konfigurieren, beginne mit einer minimalen Einrichtung und füge systematisch Optimierungen hinzu.

Anforderungen und Schlüsselgenerierung

Stelle sicher, dass dein Linux-Server die wireguard-tools installiert hat (Kernel 5.6+ bevorzugt) und der UDP-Port 51820 offen ist. Generiere Server-Schlüssel mit entsprechenden Berechtigungen:

umask 077

wg genkey | tee /etc/wireguard/privatekey | wg pubkey > /etc/wireguard/publickey Minimale Serverkonfiguration

Erstelle /etc/wireguard/wg0.conf:

[Interface]

Address = 10.0.0.1/24

PrivateKey = <SERVER_PRIVATE_KEY>

ListenPort = 51820

# MTU = 1440 (für die automatische Auswahl nicht festlegen oder nach dem Testen festlegen)

[Peer]

PublicKey = <CLIENT_PUBLIC_KEY>

AllowedIPs = 10.0.0.2/32

PersistentKeepalive = 25 # wird normalerweise auf dem NAT-Client festgelegt, auf dem Server nicht erforderlich Ersetze Schlüssel und lege ein privates /24-Netzwerk fest.

Firewall- und Netzwerk-Konfiguration

Eine ordnungsgemäße Firewall-Konfiguration ist entscheidend für die Leistung und Konnektivität von WireGuard. Richte diese Regeln ein, bevor du den Dienst startest.

Grundlegende Firewall-Einrichtung:

# WireGuard-UDP-Port zulassen

sudo iptables -A INPUT -p udp --dport 51820 -j ACCEPT

# Für den Internetzugang über den Tunnel IP-Weiterleitung und NAT aktivieren

echo 'net.ipv4.ip_forward=1' | sudo tee /etc/sysctl.d/99-sysctl.conf sudo sysctl --system sudo iptables -t nat -A POSTROUTING -o eth0 -j MASQUERADE Ersetze eth0 durch das Interface deines Servers zur Internetverbindung.

NAT- und Firewall-Traversierung: WireGuard verarbeitet NAT automatisch. Clients, die sich hinter NAT befinden, benötigen keine spezielle Konfiguration. Wenn ein Client eingehende Verbindungen über NAT empfangen muss, sollte „PersistentKeepalive = 25“ zur Peer-Konfiguration des Clients hinzugefügt werden. Dadurch bleibt die NAT-Zuordnung aktiv, indem alle 25 Sekunden Keepalive-Pakete gesendet werden.

Fehlerbehebung: Wenn WireGuard eine Verbindung herstellt, die Clients jedoch das Internet nicht erreichen können, überprüfe ob IP-Weiterleitung mit sysctl net.ipv4.ip_forward aktiviert ist und ob NAT mit iptables -t nat -L -v funktioniert.

Aktivieren und Überprüfen

Starte WireGuard und überprüfe die Konnektivität:

sudo systemctl enable --now wg-quick@wg0

sudo wg show MTU-Optimierung

Einfach beginnen: Lege MTU nicht fest, sodass wg-quick automatisch auswählt wird; überprüfe dies dann mit ip link show wg0.

Beim manuellen Einstellen: Finde PMTU zu der öffentlichen IP deines Servers mit ping -M do -s <size> <server_ip> (beginne mit 1472) und ziehe den Encapsulation-Overhead (~60B IPv4, ~80B IPv6) ab. Setze dies als MTU in jedem Peer [Interface], starte neu und führe die parallelen Stream-Tests (ping -M do -s <size> <server_ip>, beide Richtungen) erneut aus.

Finale Checks

Vergewissere dich, dass Handshakes mit Clients stattfinden und das Internet-Routing wie erwartet funktioniert. Führe nach Änderungen an MTU und Firewall immer Benchmarks durch, um die Auswirkungen auf die Leistung zu messen. Weitere Informationen findest du im offiziellen WireGuard-Quick-Start.

Fortgeschrittene Performance-Konzepte

Um WireGuard über die Grundkonfiguration hinaus zu optimieren, solltest du dich darauf konzentrieren, die letzten 10 bis 20 % Leistungssteigerung durch systematische Kernel- und Hardwareoptimierungen zu erreichen. Mach schrittweise Änderungen und überprüfe nach jeder Anpassung die Ergebnisse.

Offload-bewusstes Tunneling

WireGuard profitiert echt von den Kernel-Batching-Features (GRO/GSO), die den CPU-Overhead pro Paket reduzieren. Stell sicher, dass diese Offloads auf deiner zugrunde liegenden Netzwerkkarte aktiviert sind, und deaktiviere sie nur zum Debuggen:

# Überprüfe, ob die Entladungen funktionieren

ethtool -k eth0 | grep -E 'gro|gso' Moderne Treiber (virtio-net, ENA, gVNIC auf VMs; Intel/Broadcom auf Bare Metal) unterstützen diese Funktionen. Traffic Shaping kann bei der Latenz helfen, reduziert jedoch in der Regel den Spitzendurchsatz.

Parallelität und CPU-Skalierung

Einzelne Datenströme stauen sich oft auf einem CPU-Kern oder in einer RX-Warteschlange. Nutzt mehrere parallele Streams für Massentransfers – deine Benchmarks sollten echte Nutzungsmuster zeigen. Auf Bare Metal Servern sind die richtige IRQ-Verteilung und Multi-Queue-NICs echt wichtig. Selbst in VMs mit begrenztem RSS verbessern parallele Streams immer noch die Leistung.

Wenn iperf3 -P 4 nicht linear skaliert, überprüfe ob die CPU-Kerne zu 100 % ausgelastet sind oder ob einzelne Queues den gesamten Verkehr abwickeln.

CPU- und Systemoptimierung

WireGuard ist trotz seiner Effizienz CPU-gebunden. Stabile Taktraten während des Tests mithilfe des Leistungsreglers aufrechterhalten:

# Performance-Governor einstellen

echo performance | sudo tee /sys/devices/system/cpu/cpu*/cpufreq/scaling_governor Bei NUMA-Systemen mit mehreren Sockeln solltest du Netzwerkunterbrechungen und WireGuard-Endpunkte auf demselben Sockel lassen, um Probleme zwischen den Knoten zu vermeiden.

Kernel- und Treiberverbesserungen

Neuere Kernel bieten bessere UDP-Segmentierung und Optimierungen des Empfangspfades. Halte das Systeme aktuell und bevorzuge:

- In-Kernel WireGuard (Kernel 5.6+) gegenüber Userspace-Implementierungen

- Multi-Queue-fähige Treiber

- Moderne Firmware deiner Netzwerkkarten

TCP-Leistung innerhalb von Tunneln

Der meiste Anwendungsdatenverkehr wird über TCP innerhalb des UDP-Tunnels von WireGuard übertragen. Eine geringere Latenz und weniger Datenverluste helfen TCP, erneute Übertragungen zu vermeiden. Für lange Strecken oder verlustbehaftete Pfade solltest du eine BBR-Überlastungskontrolle an beiden Endpunkten in Betracht ziehen:

# Teste BBR (Leistungsauswirkungen überprüfen)

echo 'net.ipv4.tcp_congestion_control=bbr' >> /etc/sysctl.conf Fazit: Wenn MTU/MSS und Benchmarking optimiert sind, konzentriere dich auf intakte Offloads, echte Parallelität, stabile CPU-Leistung und moderne Kernel-/Treiber-Stacks. Überprüfe jede Änderung einzeln.

FAQ für WireGuard Performance

Wie funktioniert WireGuard?

WireGuard erstellt verschlüsselte Peer-to-Peer-Verbindungen zwischen Geräten mittels öffentlicher Schlüssel-Authentifizierung. Es läuft im Linux-Kernel, um maximale Geschwindigkeit und Effizienz zu erreichen, im Gegensatz zu älteren VPN-Protokollen, die mehr Overhead brauchen.

Verwendet WireGuard TCP oder UDP?

WireGuard verwendet nur UDP. Diese Wahl hält den Overhead niedrig und erlaubt dem Kernel, Batching/Offloads (GRO/GSO) für hohen Durchsatz anzuwenden. Wenn ein Netzwerk UDP blockiert, kannst du WireGuard in TCP/HTTPS über generische Wrapper tunneln, solltest jedoch mit zusätzlicher Latenz und möglichen Verlangsamungen rechnen. Aus Performance-Gründen wird natives UDP stark bevorzugt.

Wie überprüfe ich, ob WireGuard funktioniert?

Um zu überprüfen, ob WireGuard funktioniert, führe den wg-Befehl auf einem der verbundenen Geräte aus und suche nach einem Zeitstempel „latest Handshake“ sowie steigenden Übertragungszählern. Diese bestätigen, dass die Peers erfolgreich Schlüssel ausgetauscht haben und Verkehr übermitteln. Du kannst die Verbindung auch überprüfen, indem du die WireGuard-Tunnel-IP-Adresse des Peers anpingst, z. B. 10.0.0.1. Für eine schnelle Geschwindigkeitsprüfung sollte der iperf3-Test mit mehreren parallelen Streams (z. B. iperf3 -P 4) über den Tunnel durchgeführt und das Ergebnis mit einem Test ohne VPN verglichen werden. Wenn du Zeitüberschreitungen oder langsame Geschwindigkeiten feststellst, vergewissere dich, dass deine Firewall UDP-Datenverkehr auf Port 51820 zulässt, dass beide Peers übereinstimmende AllowedIPs-Konfigurationen haben und überprüfe deine MTU- und MSS-Einstellungen, um Fehlkonfigurationen auszuschließen.

Lass die MTU erstmal ungesetzt – wg-quick wählt einen routingfähigen Wert aus. Wenn du sie manuell einstellst, leite sie aus der gemessenen PMTU ab (typische Startpunkte: ~1440 für IPv4, ~1420 für IPv6 bei 1500-Byte-Verbindungen) und teste dann erneut.

Warum ist meine WireGuard-Geschwindigkeit niedriger als die Basis-Geschwindigkeit?

Drei häufige Übeltäter: falsches MTU/MSS (Fragmentierung/Retransmits), deaktivierte GRO/GSO-Offloads oder ein Single-Flow-Limit (behebe dies mit parallelen Streams, z. B. -P 4/8). Führe die Baseline-vs.-Tunnel-Matrix aus dem Benchmarking-Kapitel nochmal durch, um den Engpass zu finden.