DeepSeek AI ist ein bedeutender Fortschritt im Bereich der Open-Source-Sprachmodelle. Es bietet leistungsstarke Analysefähigkeiten – ganz ohne spezialisierte GPU-Hardware. In Kombination mit Ollama, einem schlanken Tool zur Modellverwaltung, entsteht eine effiziente Lösung, um KI-Modelle lokal auszuführen und gleichzeitig Datenschutz sowie Performance optimal zu steuern

Warum DeepSeek selbst hosten?

Wenn du DeepSeek auf deinem eigenen Contabo-Server betreibst, profitierst du von mehr Datenschutz und Sicherheit. Das ist besonders wichtig, nachdem Sicherheitsforscher kürzlich eine ungeschützte DeepSeek-Datenbank entdeckt haben – mit sensiblen Daten wie Chat-Verläufen, API-Schlüsseln und Backend-Details.

Mit Self-Hosting bleiben alle Informationen in deiner eigenen Infrastruktur. So vermeidest du Sicherheitsrisiken und stellst gleichzeitig sicher, dass deine Umgebung GDPR- und HIPAA-konform ist.

Revolutionäre Leistung auf CPU-Basis

DeepSeek-Modelle laufen effizient auf CPU-basierten Systemen – ganz ohne teure GPU-Hardware. Das macht fortschrittliche KI für mehr Nutzer zugänglich. Egal, ob du das 1.5b- oder 14b-Modell nutzt, DeepSeek funktioniert zuverlässig auf gängigen Server-Konfigurationen – inklusive Virtual Private Servern (VPS).

Lokale Kontrolle und maximale Flexibilität

Mit Self-Hosting hast du vollen API-Zugriff und komplette Kontrolle über die Modelleinstellungen. So kannst du DeepSeek individuell anpassen, Sicherheitsmaßnahmen optimieren und es nahtlos in deine bestehenden Systeme integrieren.

Dank Open-Source bietet DeepSeek volle Transparenz und ermöglicht kontinuierliche Verbesserungen durch die Community. Damit ist es die perfekte Wahl für alle, die Wert auf Leistung und Datenschutz legen.

DeepSeek bei Contabo: Schritt-für-Schritt Installation

Systemvoraussetzungen

Bevor du DeepSeek auf deinem Contabo-Server installierst, stelle sicher, dass Ubuntu 22.04 LTS auf deinem System läuft.

Hinweis: Wir empfehlen die Verwendung unserer VDS M-XXL Modelle, da sie die nötigen Ressourcen für optimale Performance bieten. Pläne mit geringerer Ausstattung könnten zwar funktionieren, beeinträchtigen aber definitiv die Leistung des LLM.

Exklusiv: Contabo’s vorkonfiguriertes DeepSeek-Image

Contabo setzt neue Maßstäbe als erster und einziger VPS-Anbieter, der ein fertig vorkonfiguriertes DeepSeek-Image bereitstellt. Damit entfällt der komplizierte Einrichtungsprozess, und du kannst in Minuten starten.

Unser vorkonfiguriertes Image sorgt für optimale Leistungseinstellungen und eine sofort einsatzbereite Umgebung.

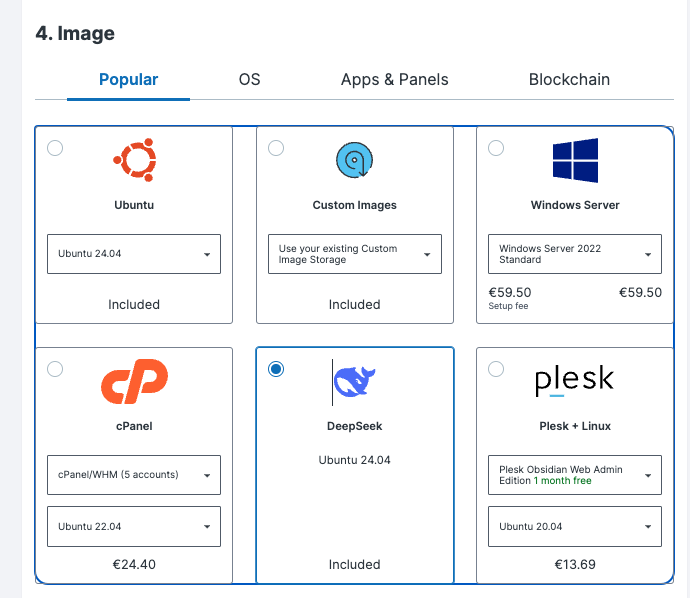

So wählst du das vorkonfigurierte DeepSeek-Image bei der Server-Einrichtung aus:

- Gehe zu Schritt 4 „Image“ im Produktkonfigurator

- Wähle das DeepSeek Image aus den verfügbaren Optionen

- Fahre mit der Server-Konfiguration fort

Mit diesem vorkonfigurierten Image kannst du sofort loslegen und hast gleichzeitig genug Freiraum, um die Leistung des Modells weiter zu testen und zu optimieren. Sobald dein Server bereitgestellt ist, kannst du DeepSeek sofort nutzen – ohne zusätzliche Installation.

Manuelle Installation

Falls du eine individuelle Einrichtung bevorzugst, kannst du DeepSeek manuell installieren. Der Prozess ist unkompliziert, erfordert aber einige Schritte. Hier ist die Anleitung:

Damit DeepSeek reibungslos funktioniert, muss dein Contabo-Server mit Ubuntu 22.04 LTS laufen.

Gehe zunächst sicher, dass dein System up-to-date ist:

sudo apt update && apt upgrade –yAls nächstes kannst du Ollama installieren. Ollama ist ein schlankes Tool zur Modellverwaltung und kümmert sich um den DeepSeek-Deployment-Prozess:

curl -fsSL https://ollama.com/install.sh | shNach der Installation musst du den Ollama-Service starten, um dein Modell bereitzustellen:

sudo systemctl start ollamaJetzt kannst du dein gewünschtes DeepSeek-Modell abrufen. Die 14b-Version bietet eine hervorragende Balance zwischen Leistung und Ressourcennutzung:

ollama pull deepseek-r1:14bSobald der Download abgeschlossen ist, ist dein Server bereit für den Einsatz von DeepSeek AI.

Modell-Deployment

Nach der Installation kannst du DeepSeek direkt nutzen. Führe das Modell direkt aus, um es interaktiv zu verwenden:

ollama run deepseek-r1:14bFalls du DeepSeek in deine Anwendungen integrieren möchtest, starte den API-Service:

ollama serveÜberprüfung der Installation

Stelle sicher, dass alles korrekt installiert wurde, indem du folgende Checks ausführst:

ollama listollama run deepseek-r1:14b "Hallo, bitte überprüfe, ob du korrekt arbeitest."Wenn diese Tests erfolgreich sind, ist dein DeepSeek-Setup bereit!

Modellkompatibilität und Systemanforderungen

Übersicht der Modellgrößen

DeepSeek bietet Modelle in verschiedenen Größen, die auf unterschiedliche Anforderungen zugeschnitten sind:

| Modellversion | Größe | Erforderlicher RAM | Empfohlener Plan | Einsatzgebiete |

| deepseek-r1:1.5b | 1.1 GB | 4 GB | VDS M | Grundlegende Aufgaben, läuft auf Standard-Laptops, ideal für Tests und Prototyping |

| deepseek-r1:7b | 4.7 GB | 10 GB | VDS M | Textverarbeitung, Codierung, Übersetzungen |

| deepseek-r1:14b | 9 GB | 20 GB | VDS L | Leistungsstark für Codierung, Übersetzungen und Texterstellung |

| deepseek-r1:32b | 19 GB | 40 GB | VDS XL | Erreicht oder übertrifft OpenAIs o1 mini, ideal für erweiterte Analysen |

| deepseek-r1:70b | 42 GB | 85 GB | VDS XXL | Für Enterprise-Anwendungen, komplexe Berechnungen und fortgeschrittene KI-Analysen |

Je nach Anforderungen kannst du das passende Modell für dein AI-Hosting auf Contabo wählen.

Tipps zur Ressourcenverteilung

Ein effizientes Speichermanagement ist entscheidend für eine optimale Performance. Stelle immer das Doppelte der Modellgröße an RAM zur Verfügung, um einen reibungslosen Betrieb zu gewährleisten. Zum Beispiel läuft das 14b-Modell (9 GB) am besten mit 20 GB RAM, um sowohl das Laden des Modells als auch die Verarbeitung effizient zu ermöglichen.

Bezüglich des Speichers: NVMe-Laufwerke sind die beste Wahl für schnellere Modellladezeiten.

Warum Contabo für DeepSeek-Hosting wählen

Contabos Server bieten leistungsstarken NVMe-Speicher, ein hohes monatliches Traffic-Kontingent (32 TB) und wettbewerbsfähige Preise ohne versteckte Gebühren. Mit Rechenzentren an 12 Standorten in 9 Regionen auf 4 Kontinenten bietet Contabo eine globale Reichweite für Ihre KI-Bereitstellungen. Das Netzwerk umfasst mehrere Standorte in Europa, den Vereinigten Staaten (New York, Seattle, St. Louis), Asien (Singapur, Tokio), Australien (Sydney) und Indien. Die Kombination aus zuverlässiger Hardware und kostengünstigen Tarifen macht es zu einer idealen Wahl für selbst gehostete KI-Anwendungen.

Abschließende Worte zum DeepSeek Hosting

Die Kombination aus den leistungsfähigen und effizienten Modellen von DeepSeek und einer soliden Server-Infrastruktur eröffnet völlig neue Möglichkeiten für Unternehmen, die Wert auf Datenschutz und Performance legen.

Wir entwickeln uns stetig weiter und werden diesen Bereich kontinuierlich ausbauen. Dieses vorkonfigurierte Image ist nur der Anfang – unser Ziel ist es, fortschrittliche KI-Technologien einfacher zugänglich und effizient verwaltbar zu machen. Bleib dran!