Ein ausführlicher Bericht inklusive Zeitplan des Vorfalls, der Schritte, die wir unternommen haben, um ihn zu beheben, und der Maßnahmen, die wir ergreifen, um in Zukunft besser darauf zu reagieren.

Was ist genau passiert?

Am 2. September 2024 wurden alle VPS, Dedicated Server und Object Storage-Instanzen im Nürnberger Rechenzentrum unzugänglich. Das Customer Control Panel, der Support per E-Mail und Telefon sowie das Aufgeben neuer Bestellungen funktionierten ebenfalls nicht mehr.

Warum waren die Instanzen der Kunden und die Systeme von Contabo nicht verfügbar?

Die Instanzen der Kunden und die Contabo-Systeme (wie das Customer Control Panel und die Support-Kanäle) wurden heruntergefahren und waren deshalb nicht verfügbar, um zu verhindern, dass die Temperatur im Rechenzentrum über 40°C (104°F) steigt, was die maximale Betriebstemperatur für unsere Server und Netzwerkgeräte darstellt. Dies wurde auch getan, um Schäden an HDD-, SSD- und NVMe-Speichern zu vermeiden, die zu Datenverlust führen könnten.

Warum stieg die Temperatur im Nürnberger Rechenzentrum über 40°C?

Die Temperatur im Rechenzentrum Nürnberg stieg an, weil die Klimaanlage die Luft im Rechenzentrum nicht kühlte. Server erzeugen während des Betriebs Wärme, und ohne funktionierende Klimaanlage stieg die Temperatur über das sichere Limit. Die hohen Außentemperaturen haben die Situation zusätzlich verschärft.

Warum hat das Kühlsystem nicht funktioniert?

Das Kühlsystem hörte auf zu kühlen, weil es sich automatisch abgeschaltet hat und sich nicht wieder einschaltete.

Warum wurde das Kühlsystem automatisch abgeschaltet?

Das Kühlsystem wurde automatisch abgeschaltet, weil das Nürnberger Rechenzentrum auf die unterbrechungsfreie Stromversorgung (USV) als Notstromversorgung umgeschaltet hat. Es ist ein standardmäßiger Prozess, das Kühlsystem abzuschalten, wenn die USV die Stromversorgung übernimmt, und es einige Minuten später wieder einzuschalten, sobald entweder der Dieselgenerator einspringt oder der Strom aus dem öffentlichen Netz wiederhergestellt ist.

Warum hat das Nürnberger Rechenzentrum auf USV als Notstromversorgung umgeschaltet?

Es gab eine Spannungsschwankung im lokalen Stromnetz. Dadurch haben unsere Systeme automatisch auf die USV umgeschaltet, um die Stromversorgung durchgehend sicherzustellen, und deswegen wurde das Kühlsystem vorübergehend abgeschaltet. Die USV war für 3 Sekunden aktiv, bevor die Hauptstromversorgung wieder übernommen hat.

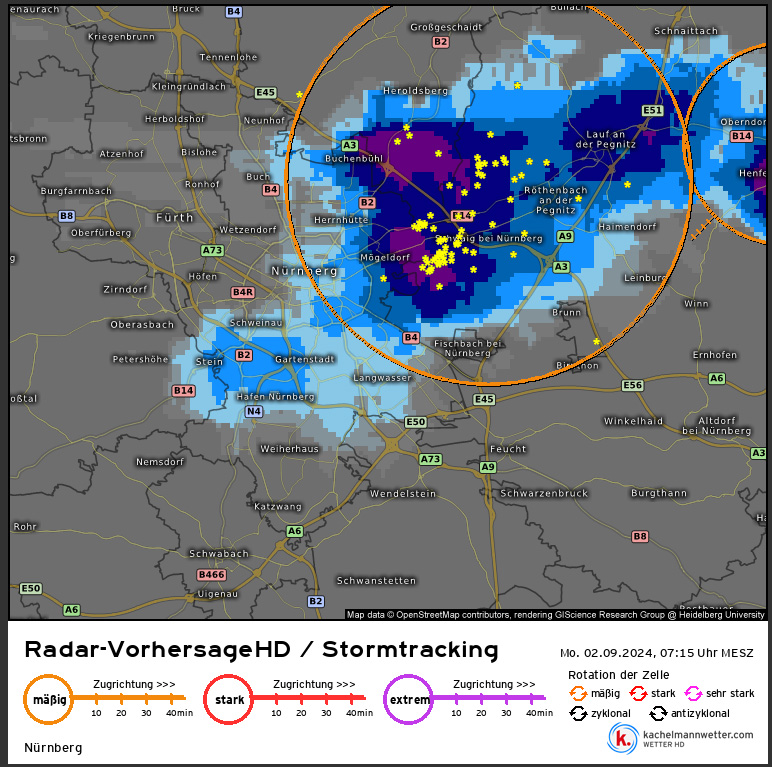

Warum gab es Spannungsschwankungen im lokalen Stromnetz?

Die Spannungsschwankungen im lokalen Stromnetz wurden durch ein starkes Gewitter mit Blitzeinschlägen in ganz Franken, besonders um Nürnberg, verursacht.

Unser Rechenzentrum ist mit Blitzableitern ausgestattet, um es vor den Auswirkungen eines direkten Blitzeinschlags zu schützen. Allerdings können Blitzableiter nicht die Auswirkungen von Blitzeinschlägen abmildern, die andere Strukturen wie Übertragungsleitungen treffen, die sich manchmal mehrere Kilometer von unserem Gebäude entfernt befinden.

Warum hat sich das Kühlsystem nicht automatisch wieder eingeschaltet?

Das Kühlsystem hat sich wegen einer Störung im Steuerbus nicht automatisch wieder eingeschaltet. Auch unsere manuellen Versuche, die Kühlsysteme neu zu starten, waren erfolglos. Die Kühlung konnte erst wiederhergestellt werden, nachdem ein autorisierter Techniker der Firma, die die Kühleinheiten bereitstellt, einen Hard-Reboot durchgeführt hat.

Exakte Timeline des Vorfalls

Hier ist eine detaillierte Timeline des Vorfalls (CEST-Zeit), die unsere Reaktion und die wichtigsten Maßnahmen zur Wiederherstellung der Dienste beschreibt:

2. Sep 2024, 07:14 Uhr: Spannungsschwankungen erkannt, Stromversorgung automatisch auf USV umgeschaltet. Server laufen weiter, Kühlsysteme werden abgeschaltet.

2. Sep 2024, 07:14 Uhr: Stromversorgung aus dem Netz nach 3 Sekunden wiederhergestellt, Kühlsystem startet nicht neu.

2. Sep 2024, 07:14 Uhr: Überwachungsalarm über die Umschaltung auf USV und das Ausfallen der Kühler wird an das Rechenzentrumspersonal gesendet. Der Vorfallprozess wurde gestartet. Die Temperatur beginnt zu steigen.

2. Sep 2024, 07:33 Uhr: Überwachungsalarm, dass der erste Serverraum eine kritische Temperatur erreicht hat, das Personal bewertet die Situation.

2. Sep 2024, 08:13 Uhr: Erste Contabo-Systeme werden heruntergefahren.

2. Sep 2024, 08:41 Uhr: Team vor Ort stellt fest, dass sie die Kühlsysteme nicht manuell einschalten können. Kurz darauf wird ein Techniker der Kühlsystemfirma angefordert. Der Techniker ist jedoch nicht sofort verfügbar, da er bereits bei anderen Unternehmen in der Region, die von einem ähnlichen Problem betroffen sind, im Einsatz ist.

2. Sep 2024, 11:30 – 12:08 Uhr: Die Temperatur überschreitet in einem Serverraum nach dem anderen die sichere Grenze, Server werden heruntergefahren, um Schäden und Datenverlust zu vermeiden.

2. Sep 2024, 12:55 Uhr: Der Regen hört auf, wodurch die Rauchschutzklappen zur Belüftung geöffnet werden können. Industrielle Ventilatoren werden aktiviert, um die heiße Luft schneller zu entfernen. Die Temperatur beginnt zu sinken.

2. Sep 2024, 13:55 Uhr: Kernnetzwerkverbindungen und -komponenten werden wiederhergestellt.

2. Sep 2024, 14:25 Uhr: Kühlsystem startet nach dem Besuch eines externen Technikers wieder.

2. Sep 2024, 15:05 Uhr: Server werden nach und nach wieder hochgefahren, da die Temperatur weiter sinkt.

2. Sep 2024, 15:30 Uhr: Der Object Storage-Cluster ist wieder online.

2. Sep 2024, 15:42 Uhr: Contabo-Systeme, einschließlich des Customer Control Panels, sind vollständig wiederhergestellt.

2. Sep 2024, 18:00 Uhr: 95% der Server sind wieder online.

3. Sep 2024, 19:55 Uhr: Vorfall abgeschlossen. Einzelne Berichte über Probleme mit Virtual und Dedicated Servern werden wie gewohnt vom technischen Support-Team bearbeitet.

Wie sieht es mit Redundanz aus?

Alle kritischen Systeme im Nürnberger Rechenzentrum wurden mit N+1-Redundanz eingerichtet. Das bedeutet, dass beispielsweise bei Bedarf von 2 Kühleinheiten für die Klimaanlage (N=2), insgesamt 3 Einheiten installiert wurden (N+1 = 2+1 = 3). Dasselbe Prinzip gilt auch für andere wichtige Systeme wie Stromversorgung oder Internetverbindung. Das oben beschriebene Umschalten auf die USV ist ein Beispiel für die funktionierende Redundanz der Stromversorgung. Leider konnten die vorhandenen Redundanzen den Ausfall, wie oben beschrieben, nicht verhindern.

Wie sieht es mit Fallback-Systemen für Contabo-Systeme (wie das Customer Control Panel oder Support-Kanäle) aus?

Wir haben einen Notfallplan für Contabo-Systeme (wie das Customer Control Panel oder die Support-Kanäle), und dieser wurde wie geplant aktiviert. Bevor wir auf alternative Standorte umschalten konnten, wurden die Systeme in Nürnberg allerdings bereits wiederhergestellt.

Erkenntnisse und Maßnahmen

Erstens haben wir uns entschieden, alle Kunden aus Nürnberg in unser neu gebautes Hub Europa Rechenzentrum zu migrieren. Diese Anlage wurde so konzipiert, dass sie eine Verfügbarkeit von 99,982% erreicht, wie sie für Tier-3-Rechenzentren erforderlich ist, und bietet robustere Sicherheitsmechanismen gegen Vorfälle wie den oben beschriebenen. Der Migrationsprozess hat bereits begonnen, und betroffene Kunden werden direkt informiert.

Zweitens werden wir unsere Notfallpläne und Fallback-Prozesse für Contabo-Systeme wie das Customer Control Panel und die Support-Kanäle überarbeiten, um deren höhere Verfügbarkeit auch bei Zwischenfällen zu gewährleisten.

Drittens werden wir unser Incident-Management überarbeiten, um Vorfälle schneller zu lösen und unsere Kunden während solcher Ereignisse besser zu informieren. Wir wissen, dass unsere Partner auf uns zählen, und arbeiten aktiv daran, die deutsche Qualität zu verkörpern, die uns ausmacht.

Noch einmal danken wir unseren Kunden für ihre Geduld und ihr Verständnis während dieses Vorfalls und versichern, dass wir uns dafür einsetzen, ähnliche Probleme in Zukunft zu verhindern. Wir werden außerdem transparenter über alle Maßnahmen berichten, die wir ergreifen, um die Verfügbarkeit eurer Server in allen unseren Rechenzentren weltweit zu sichern.